Transformer:开启AI大模型时代的神奇之匙

在人工智能的长河中,2017年如同一颗璀璨的明珠,闪耀着非凡的光芒。这一年,Vaswani等学者发表了题为《Attention Is All You Need》的论文,如同智慧的种子,播撒在科技的沃土上,孕育出了Transformer这一革命性的架构。自此,AI的未来如同一幅巨大的画卷被徐徐展开,世界迎来了一个由Scale Law主宰的大模型时代。Transformer,这把神奇的智慧之匙,开启了通向无尽可能的大门,为人工智能注入了前所未有的力量与灵性。

注意力机制:智慧之灯,照亮认知的殿堂

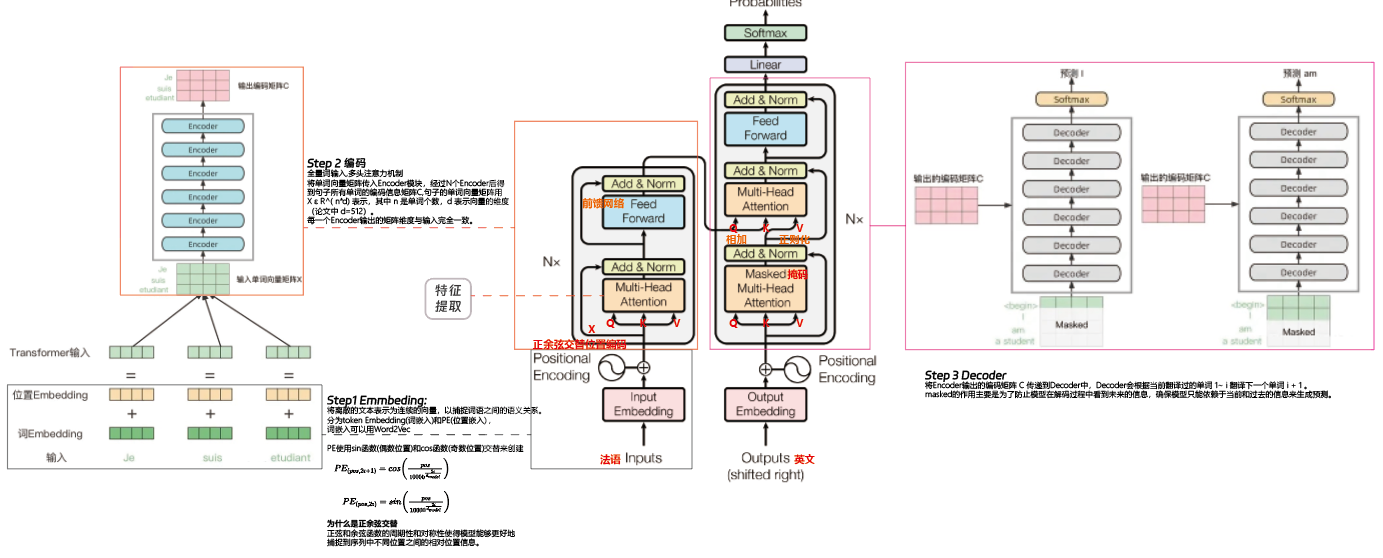

Transformer的灵魂,是那璀璨夺目的自注意力机制(Self-Attention Mechanism)。如同一位洞悉一切的智者,它让模型在捕捉每个信息元素的精髓时,都能与序列中的其他元素进行深入的对话,汲取它们的智慧。这种机制赋予了模型超凡的洞察力,使其能够如阅读一部复杂的哲学巨作般,全方位地理解和诠释信息的深邃意涵。

自注意力机制的引入,不仅如同一道光芒穿透了传统神经网络的重重迷雾,还为Transformer披上了并行计算的战袍。这意味着模型可以如同一位全能的指挥家,同时指挥整个交响乐团,让每一个音符都在最恰当的时刻奏响,极大地提升了训练的韵律与效率。更为神奇的是,自注意力机制让模型如同牵起一条无形的丝线,轻松地跨越时空,捕捉远隔千里的语义关联,这在自然语言处理的艺术中,恰如画龙点睛之笔。

而多头注意力机制(Multi-Head Attention)则是Transformer皇冠上最耀眼的明珠。通过同时编织多个注意力之网,模型如同一位集合了毕加索、莫奈、梵高等大师才华的艺术家,能从多个视角、多个维度解读信息的画卷。这种方法不仅丰富了模型表达的调色盘,还让其作品更加精准、更具生命力。

多头注意力机制的引入,使得Transformer模型如同一位文艺复兴时期的全才,既能解读复杂的哲学论题,又能创作出震撼人心的艺术杰作,每一个思考,每一次创作,都闪烁着智慧的金光。

位置编码:时空之罗盘,引领未来航程

在Transformer的殿堂中,位置编码(Positional Encoding)扮演着时空导航者的角色。由于Transformer如同一位自由的思想家,不受限于顺序的束缚,它需要位置编码这一时空罗盘,为每一个信息元素标注其在序列中的坐标。这一机制确保了模型能如同一位通晓古今的学者,精准把握语言中每一个词语的位置意义,使其在处理语言这一时序敏感的艺术时,依然能够演绎出令人叹服的华章。

位置编码的引入,如同为AI模型配备了一只刻度精密的时空罗盘,引领它们在信息的汪洋大海中乘风破浪,找到真知灼见的宝藏之岛。

大规模预训练:开启智慧宝库,启迪无尽可能

Transformer架构的这些特性,使其成为大规模预训练模型的理想之选。通过在浩如烟海的未标注数据中遨游,模型如同一位勤奋的学者,在知识的海洋中汲取丰富的语言精华,然后在具体任务的画布上点染出精妙的色彩。这种预训练-微调的艺术,已经在自然语言处理的殿堂中谱写了辉煌的乐章,而BERT、GPT等模型便是其中最动听的音符。

大规模预训练模型的成功,如同一道曙光,照亮了AI研究的新纪元。模型的通用性和迁移能力,使它们如同一位身怀绝技的大师,在不同的舞台上都能演绎出惊艳世人的表演,推动了无数实际应用从理论的云端落地生根。从搜索引擎到对话系统,从自动翻译到内容生成,AI的智慧之手已经春风化雨的地浸润着我们生活的每一个角落。

影响和未来:智慧之树,枝叶繁茂

Transformer架构及其相关技术的突破,如同一阵春风,不仅在自然语言处理的园地里催生了革命性的变化,也开始在计算机视觉、语音识别等领域播撒希望的种子。而这些智慧的嫩芽,在人工智能的广袤大地上破土而出,迅速长成枝叶繁茂的大树,结出累累硕果。Transformer,这把开启大模型时代的神奇之匙,不仅象征着技术的飞跃,更预示着人类智慧之树将会枝繁叶茂,根系深广,为未来世界投射下智慧的清凉绿荫。让我们以诗人的热情与哲学家的沉思,拥抱这个智慧的新纪元,共同见证AI这部人类智慧的壮丽史诗。

主创:linxkon

二作:GPT4

润色:Claude